В рамках конференции Supercomputing 2023 состоялась презентация ускорителя вычислений Nvidia H200. Он базируется на архитектуре Hopper и являет собой обновлённую версию модели H100. Главная особенность новинки кроется в переходе на более высокоскоростные и ёмкие микросхемы памяти HBM3e. Благодаря этому она обеспечивает лучшую производительность при работе с нейросетями, вроде больших языковых моделей.

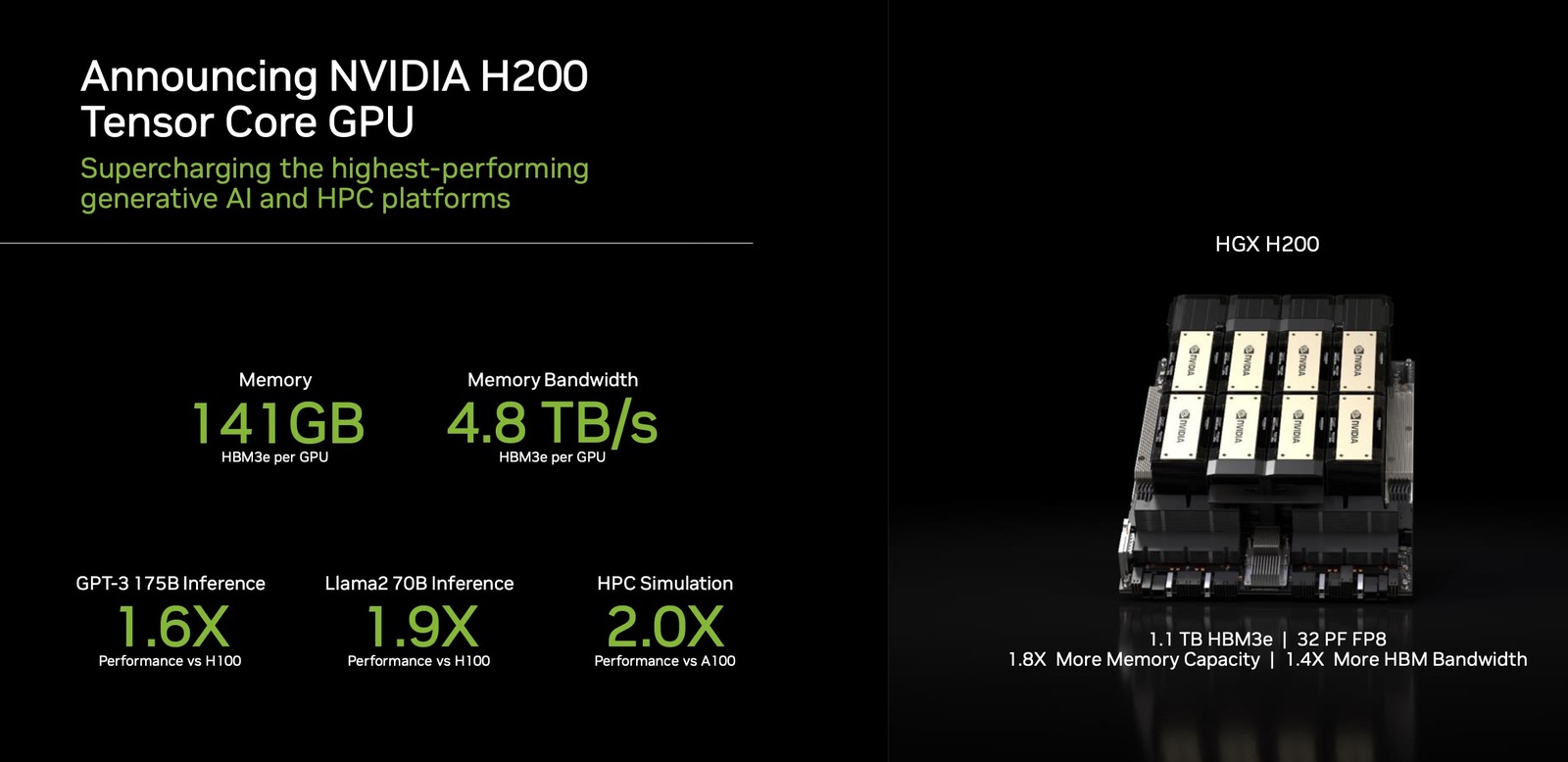

Детальные спецификации H200 «зелёные» не раскрывают, но судя по заявленной грубой вычислительной мощности, в основе ускорителя лежит тот же процессор, что и в H100. В то же время объём буфера вырос с 80 до 141 ГБ, а его пропускная способность — с 3,35 до 4,8 Тбайт/с. Этот апгрейд, к примеру, улучшил производительность при работе с обученной моделью GPT-3 в 1,6 раза.

Вместе с новым ускорителем была представлена платформа Nvidia HGX H200. Одна такая станция будет использовать четыре или восемь H200, предлагая суммарно до 1,1 ТБ высокоскоростной памяти HBM3e. Поставки новых ИИ-ускорителей начнутся во втором квартале следующего года.

Источник:

Nvidia