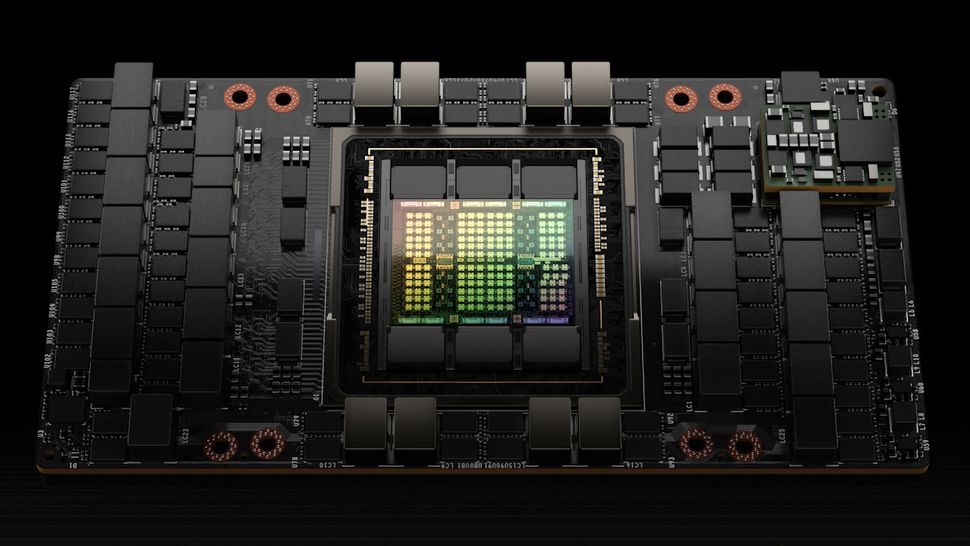

На фоне бума искусственного интеллекта компания Nvidia активно продает свои ускорители вычислений H100. Отгрузка этих устройств идет буквально тоннами. Каждое такое устройство потребляет 700 Вт электроэнергии, что вполне сопоставимо со среднестатистическим домохозяйством. И в скором времени общее потребление таких устройств будет сопоставимо с небольшими европейскими странами. По оценкам французской компании Schneider Electric в октябре общее энергопотребление центров обработки данных для ИИ было сопоставимо с энергопотреблением Кипра.

Инженеры из Microsoft подсчитали, что к концу 2024 года, когда будут развернуты миллионы графических процессоров Nvidia H100, они будут потреблять электроэнергию на уровне крупных американских городов — больше, чем в Фениксе, но меньше, чем в Хьюстоне. Если предположить, что Nvidia продаст 1,5 миллиона графических процессоров H100 в 2023 году и два миллиона графических процессоров H100 в 2024 году, то к концу следующего года будет развернуто 3,5 миллиона таких процессоров. В общей сложности они будут потреблять колоссальные 13 091 820 000 кВт∙ч электроэнергии в год или 13091,82 ГВт∙ч. Это сопоставимо с потреблением электроэнергии таких стран, как Грузия, Литва или Гватемала.

Внушительные цифры, но вряд ли это остановит внедрение таких устройств. Применение ИИ во всех сферах растет, а это потребует нового оборудования и увеличения производительности ЦОД. Также в следующем году ожидается анонс новых ускорителей Nvidia B100, которые вместе с повышенной производительностью могут получить и более высокое энергопотребление.

Источник:

Tom's Hardware