Недавно компания xAI, которая принадлежит Илону Маску, запустила самый большой вычислительный кластер в мире для обучения искусственного интеллекта. Суперкомпьютер Colossus AI получил 100 тысяч графических процессоров Nvidia и был развернут в рекордные сроки — лишь за 122 дня. И теперь мы впервые можем оказаться внутри этого вычислительного завода и посмотреть, как там все организовано, благодаря видеоролику на канале ServeTheHome.

В обзоре показали внутренне устройство огромного дата-центра, рассказали об охлаждении, организации сети и внешнего питания. xAI Colossus построен на серверных системах Nvidia HGX H100, каждая из которых содержит восемь ускорителей Nvidia H100. В одну стойку установлено по восемь таких систем, что дает 64 GPU на одну стойку.

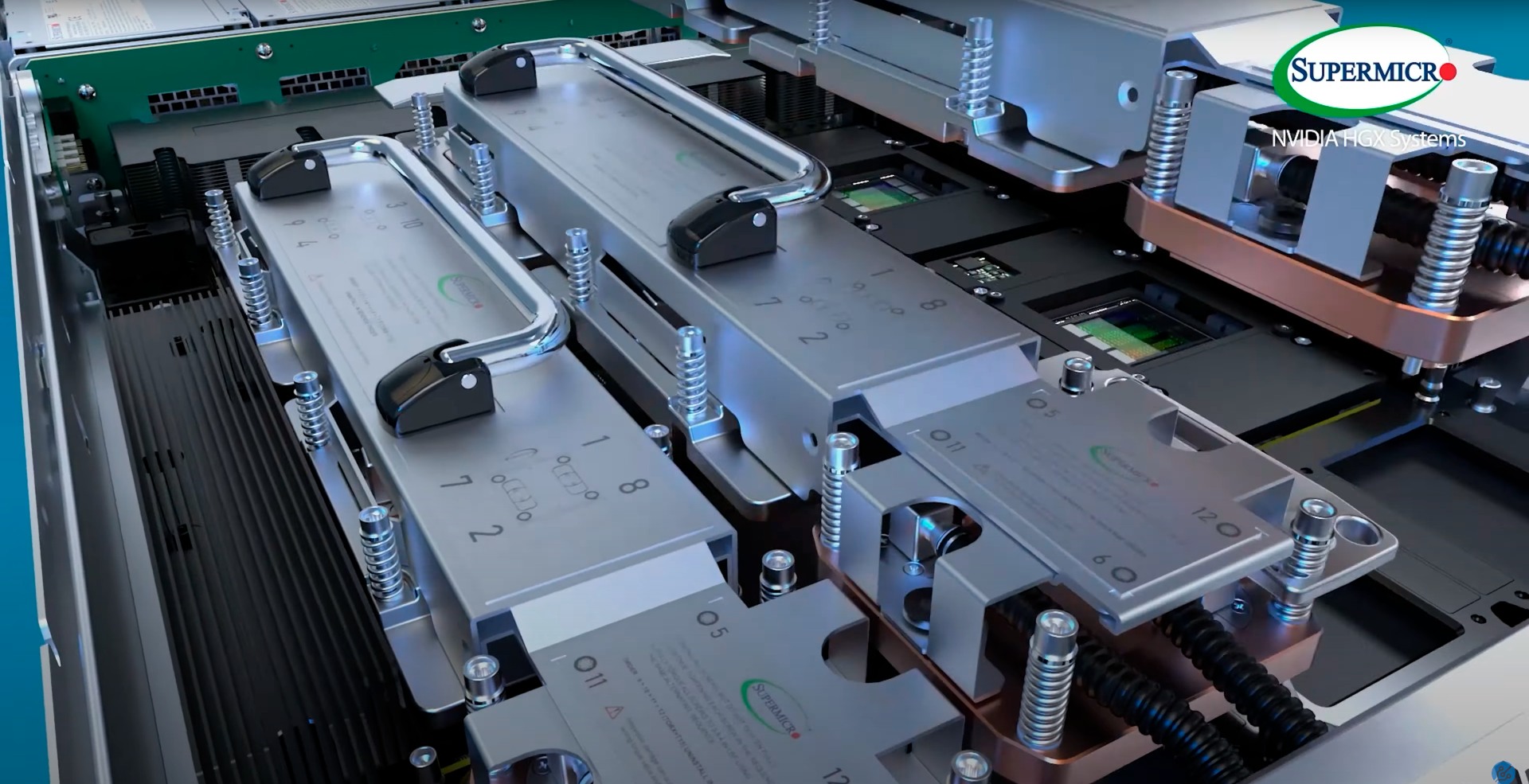

Каждая система Nvidia HGX H100 оснащена системой жидкостного охлаждения графических процессоров от Supermicro, которая предусматривает простую горячую замену охлаждения для любого GPU. Коллекторы зажаты между серверными стойками. А внизу стойки расположен блок Supermicro 4U с резервной насосной системой и системой мониторинга стойки. Стойки объединены в массивы по восемь штук, что дает 512 GPU на массив. Каждый такой массив имеет свой большой коллектор с системой распределения жидкости, четыре резервных источника питания и сетевые коммутаторы. Всего суперкомпьютер Colossus насчитывает 200 массивов и более 1500 стоек.

Столь мощная вычислительная система требует высокой производительной сетевой инфраструктуры, которая организована на базе Ethernet. Каждый графический процессор имеет свой выделенный сетевой контроллер NIC 400GbE и дополнительный контроллер 400 Гбит/с на сервер. Получается, что один сервер может передавать данные с пропускной способностью 3,6 Тбит/с. Также в видео показаны сервера хранения данных производства Supermicro, но без подробностей относительно их устройства и характеристик.

Известно, что для бесперебойного питания центра дополнительно задействовано 14 дизельных генератора. Также на объекте есть крупные батареи Tesla Megapack, который являются энергетическим буфером между электросетью и суперкомпьютером.

Суперкомпьютер Colossus используется для обучения больших моделей ИИ, включая новую модель Grok 3. На этих мощностях будут обучаться и будущие модели ИИ. Сейчас Colossus находится на первом этапе запуска. Уже планируется расширение за счет дополнительных 100 тысяч GPU Hopper (50 тысяч H100 и 50 тысяч H200). И, вероятно, это не последняя стадия расширения.

Источник:

Tom's Hardware