MLC — 2011

Прогресс не стоял на месте, и разработчики предложили в одной ячейке твердотельного накопителя определять не два состояния заряда, а больше. Технологические возможности позволяли уверенно работать с четырьмя уровнями заряда, и в массовый сегмент вышел новый тип памяти.

Маркетологи должны были показать, что новый тип гораздо гораздее прошлого. Девальвированное массовым необоснованным применением «2х!» привело к тому, что надо было выдумывать что-то посолиднее и слово MULTI оказалось кстати. Так на рынке появилась знаменитая MLC-память: Multi level cell с 2 битами на ячейку, 4 определяемыми состояниями заряда в ней. Логичнее было бы Dual level cell или Two level cell, Bi level cell и т.п. Но зачем маркетологам в логику, когда и потребителю заходит?

Но увеличение распознаваемых уровней заряда в одной ячейке вместе с утончением технологического процесса производства неизбежно привело к тому, что на физическом уровне обеспечить такую же выносливость ячеек новой памяти оказалось невозможно. Уверенное чтение после некоторого количества рабочих циклов не происходило даже с улучшенными алгоритмами коррекции ошибок в новых контроллерах — электроны разбегались как тараканы. Считается, что твердотельные ячейки в MLC-массивах способны пережить от 3000 до 10000 перезаписей. Т.е. падение ресурса на порядок по сравнению с SLC!

Примерно здесь и начинаются легенды и басни о реальном ресурсе твердотельных накопителей. Напомню, что обобщенно еще недавно твердотельные накопители в общественном сознании неспециалиста считались по этой части проблемными. Говоря проще — долго не жили, ведь только заявленный ресурс упал на порядок, а гарантированные производителями ресурсы оказывались в документации еще ниже. Заимела место невиданная в случае HDD тенденция экономии ресурса твердотельных накопителей особо экономными частными пользователями. Ведь при типично небольших объемах товарных SSD казалось, что перезаписать их несколько тысяч раз можно будет достаточно быстро! Пользователи задались вопросом сбора статистики среднесуточных записей в разных сценариях работы. Появились даже сайты, которые делили заявленный производителем ресурс конкретной модели твердотельного накопителя на среднюю суточную запись и прикидывали количество лет эффективной работы конкретного устройства. Казалось, что индустрия допустила солидный просчет так сильно снизив ресурс, но самое интересное было еще впереди.

До дыр!

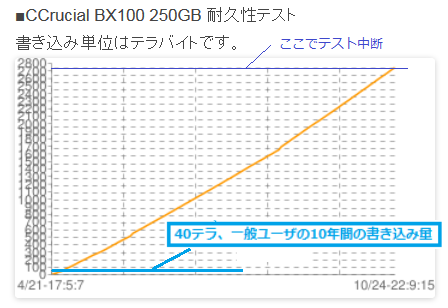

В сети можно найти много энтузиастов, которые занимались исследованиями ресурса различных твердотельных накопителей частным образом. Самих производителей памяти не так уж и много и продукт у них бывает разной степени кондиционности. Лучшее, как правило, оставляют для собственного бренда, отличное и хорошее могут продать стороннему производителю, который может и перемаркировать чипы, что-то попроще уедет в азиатские локальные бренды, а совсем уж треш пойдет в великий «ноунейм». Контроллеры тоже бывают разных производителей и разных поколений. Где-то используются DRAM-буферизация и т.п. В общем, комбинаций может быть много, и неплохо было бы увидеть результаты компаративной аналитики. И они не заставили себя долго ждать — мастера протирать SSD до дыр установили, что ресурс MLC памяти в отдельных случаях сильно превышал заявленный. Так, например, мой Crucial BX100 на 256 ГБ, используемый в «печатной машинке», где набирается этот текст, по заявлению производителя имеет ресурс в 72 ТБ. Это всего-то 300 перезаписей полного объема. По сравнению с 100 000 ресурса SLC, казалось бы, полное фиаско компании Micron! Но на практике исследователь из Японии записал на такой диск почти 3 ПБ и на этом процесс не завершился, а это уже более 10 000 перезаписей, что в 300 с лишним раз больше гарантии.

Где же закрались нестыковки? Они в методике. Многие подобные тесты построены на цикличной модели перезаписи носителя до фактической им утраты работоспособности, т.е. когда контроллер не способен больше нормально работать с массивом в результате разброда и шатания электронов в ячейках. Но это никак не является показателем т.к. в ходе теста носитель все время находится под током. А что будет, если, скажем, на петабайте завершить тест и обесточить накопитель? Насколько долго технология позволит удерживать заряд по ячейкам, т.е. сохранять информацию читаемой? Неделю, месяц, год? Есть стандарты и производитель, очевидно, посчитал, что выполнит их с запасом при оглашенном ресурсе. На практике может быть и больше. Главное, чтобы не меньше, а то исками закидают. Возможно коллективными. Конфликты с Аpple научили, что к единичному иску могут присоединиться все покупатели проблемного товара просто отправив свои данные юридической компании, которая ведет дело, в обмен на часть выплат в случае победы. А коллективный иск с тысячами истцов — это уже не финансовые, а имиджевые потери. Поэтому лучше перебдеть и занизить заявленный ресурс.

Уголок стандартизации

К слову о стандартах. Существует Joint Electron Device Engineering Council, он же JEDEC, он же Сообщество Инженеров, специализирующихся в области электронных устройств, он же комитет инженерной стандартизации полупроводниковой продукции при Electronic Industries Alliance. Собственно, они как раз и пишут партитуру по данному вопросу, которой пользуется весь оркестр производителей, представители которых туда и входят — такой себе Уроборос.

Но посмотрим на документы. Существует платный стандарт ресурсного тестирования SDD по JEDEC — SOLID STATE DRIVE (SSD) REQUIREMENTS AND ENDURANCE TEST METHOD JESD218B.01 от июня 2016. Расположен он тут. Имеющие лишние 76 долларов могут поинтересоваться. Мы же обратимся к открытым источникам и там найдем выдержку из ревизии А этого стандарта, опубликованную с разрешения JEDEC Элвином Коксом (Alvin Cox), руководителем Seagate еще в 2011 году.

В тексте накопители делятся на классы: потребительский и корпоративный. Нас интересует первый. Предполагается, что потребительский твердотельный накопитель будет работать 8 часов в день при 40 градусах Цельсия. При этом хранить данные ему положено в течение года после отключения при 30 °C. Температура тоже очень критична! О ней начиная с 12 страницы по ссылке.

Важно понимать, что носитель соответствует требованию функционального отказа (FFR) в случае, если число неисправных носителей по итогу теста меньше заданного. Т.е. стандарт подразумевает, что в течение года отключенного хранения могут не проснуться 3 из 100 накопителей даже в идеальных условиях, а народ трет поштучно!

UBER тут не про такси. Это показатель невосстановимых битовых ошибок — Unrecoverable Bit Error Ratio (UBER) и он нормируется.

Учитывая эти показатели для каждого уровня предела доверия (допуск сбоев и ошибок) можно подсчитать минимально необходимое количество экземпляров носителей для тестирования. Детальней здесь, на 224 странице.

Указанное сильно намекает, что популярные тесты живучести не особо-то и показательны для реальной жизни и нуждаются в корректировке, но тогда пострадает кликбейт у авторов.

Т.е. важно не только сколько контроллер затолкает электронов по ячейкам при постоянном в смысле качественного питания токе. Важно сколько при этом произойдет ошибок, как это потом прочитается, сколько это все пролежит без питания, насколько это приемлемо для конкретной пользовательской ниши и т.п.

На этом фоне нетрудно заметить, что НЖМД даже самых первых поколений сегодня, вероятнее всего, после включения покажут целостные данные, когда-то записанные на них. Но на них в любом случае будут действовать последствия естественного размагничивания. Оно протекает с разной скоростью в зависимости от материалов и внешних условий. Можно условно принять, что таковое происходит со скоростью примерно 1% в год и лет через 50 хранения HDD без питания, возможно, будут потери данных. На практике эта цифра будет колебаться. Но ведь никто из нас не видел жесткие диски, которые бы не читались по старости — да, поэтому лет 20–30 хранения без сильных внешних агрессивных факторов срок вполне реальный и, возможно, далеко не предельный.

Т.е. что в SSD, что в HDD есть предельные сроки хранения данных без питания. Обусловлены они разными факторами, но итог будет один — когда-то данные читаться перестанут, если физические процессы, которые ответственны за их хранение, не будут поддерживаться в нужном состоянии. При работе современный контроллер твердотельного накопителя сам перезапишет данные внутри носителя, обновив их. В случае винчестера дефрагментация частично обновит содержимое. Где-то используется технология data scrubbing — например, в RAID-контроллерах и файловых системах Btrfs и ZFS. Но для активно эксплуатируемых носителей эти моменты не так актуальны — они будут заменены на новые задолго до того, как эти проблемы повлияют на результат работы, плюс существует защита данных дублированием, избыточностью, дублированием с избыточностью в RAID, бекапами в конце концов.

Справедливости ради надо заметить, что большинство «флешек» после года-двух лежания в столе нормально прочтутся, а внутри они ближайшие родственники твердотельных накопителей.

Но мы несколько отвлеклись.

На стадии проникновения твердотельных накопителей на памяти типа MLC стало очевидно, что НЖМД неумолимо движутся в прошлое. Это не значит, что совсем скоро их не останется в продаже, но ровно три оставшихся производителя намекают нам, что их использование будет весьма нишевым.

Снижение заявленного ресурса по сравнению с SLC-накопителями оказалось не таким уж страшным. На практике потребительские накопители скорее выйдут из строя по причине производственных дефектов, скачков напряжения и прочего, чем от протирания флэш-памяти — горы вторичных накопителей ранних серий из корпоративных парков Европы и eBay.com с вполне приличными данными SMART подтверждают этот тезис.

Объемы носителей, предлагаемые рынку, окончательно утвердили их как рекомендуемые к применению в качестве системного — 120 и 256 ГБ по адекватным ценам уже не выглядели совсем куцо в качестве системных, как это было с 32 и 64 гигабайтами. Стали доступны и куда большие объемы, но они для массмаркета были несколько дороговаты, но были. И энтузиасты могли попробовать все прелести, например, игры с SSD либо беспрецедентные возможности по скоростям работы с базами данных, массивами мелких файлов и прочим.

Скорости подросли, в массовых продуктах нашлось место многоканальности, буферам из DRAM и вполне современным контроллерам, которые перечеркивали прошлые проблемы использования твердотельных накопителей. Отдельные контроллеры даже успевали сжимать входящие данные на лету и до физической памяти они доходили в сжатом виде, на лету же разворачиваясь при движении в обратном направлении. Ценой было снижение производительности, а выигрышем — борьба с усилением записи. Помашем рукой SandForce и вспомним сжатие дисков в ОС Windows, синие файлы в проводнике и т.п.

Но взгляды у разных производителей на технологии, которые могут прижиться, были разными и обкатывали их традиционно на пользователях т.к. в ином случае поезд с надписью «рынок» можно было и не догнать.

Самое главное — цены. Они стали относительно приемлемы, а вынося за скобки корпоративный сегмент, заметим, что вторичный рынок укрепил мнение о возможности и нужности применения SSD даже в среде не особо богатых пользователей. Ситуацию с ценами некстати подпортил пик поставок на рынок носимой техники. Часть производимой памяти ушла именно туда. И это была заметная часть, что не позволяло сильно снижать цены. Наоборот — наличие почти ажиотажного спроса у азиатских производителей находилось в прямом противоречии с идеей снижения цен.

Напомним, что параллельно совершенствовались производственные мощности полупроводниковых гигантов, и техпроцесс потихоньку утончался. Это позволяло повысить в натуральном выражении выход годных чипов за единицу времени с единицы затрат, т.е. с одной кремниевой «вафли» стало можно нарезать больше чипов памяти при том же их объеме. Сам процесс можно посмотреть на видео ниже — от производителя к производителю отличаться особо он не будет, но общее представление о том, как же это производится, сформирует вполне неплохо. Заодно можно оценить уровень организации и затрат.

Здесь важно заметить, что при утончении процесса в общем случае можно ожидать падения надежности ячеек памяти, т.к. на физическом уровне все становится пропорционально сложнее контролировать. С этим призвана бороться прикладная математика в виде алгоритмов коррекции ошибок контроллером твердотельного накопителя. Сегодня это удается вполне неплохо и пользователь не сильно задумывается как все устроено внутри. Но сама тенденция от этого никуда не девается. Соответственно на характеристики конечного изделия влияют множество факторов и экономические здесь не сильно вторичнее технологических.

Твердотельные накопители на MLC-памяти пошли в массы: объёмисты, быстры, надежны, относительно приемлемы по цене.

Отдельно стоит отметить, что твердотельные накопители лишь по инерции выпускаются в форм-факторах типичных НЖМД. Под такие виды исполнения есть стандартизированные крепления и возможность легкого подключения — не более. Внутри большинство твердотельных накопителей хорошо, если занимают половину отведенного физического объема.

Новые же компьютеры могут в принципе-то и вообще не иметь возможности подключения физически отдельного накопителя и, особенно в портативной технике, носитель прямо распаивается на системной плате, экономя место и вес. Да, заменить его не получится, но по логике таких производителей замена будет вместе с устройством, т.е. это не проблема с учетом приличного ресурса такого накопителя. Вероятно, само изделие устареет до протирания памяти.

Здесь дам небольшую ремарку. В ноутбуке, где пишется этот текст, системным диском установлен обозначенный ранее Сrical BX100 256GB на МLC. Заявленный ресурс производителя — 72 ТБ, японец дошел почти до 3 ПТ (хотя это не показательно, но тем не менее). Windows 10 64-bit, а у меня 8 ГБ ОЗУ, при офисном сценарии работы с кучей браузеров с десятками вкладок, а это серьезная нагрузка на кэш браузеров мелкими записями, генерирует 3–5 ГБ записи в рабочий день, если BD-rip не увлекаться. Т.е. 72 терабайта я запишу за 14400 дней или примерно 40 лет. По японскому сценарию 3 ПТ или 3 000 000 гигабайт я запишу за 600 000 дней или 1 643 года.

Если таки увлекаться крупными записями и суточно в среднем писать раза в 2–3 больше, что в обычной жизни смоделировать без узкоспециализированных нагрузок непросто, то в первом случае это гарантированные производителем 15–20 лет и вполне респектабельные лет 500 по японскому сценарию.

С учетом того, что 72 ТБ производитель мне гарантирует, на практике будет не меньше, а, скорее всего, больше. С учетом того, что большие объемы носителей по понятным причинам имеют больший гарантированный ресурс — там банально больше ячеек — вопрос практического ресурса твердотельных носителей на MLC-памяти можно закрывать совсем. Так сделали все, кто умел считать и вопрос усиления записи, выбора куда поместить файл подкачки ОС и прочие окончательно утратили актуальность. Даже безымянные китайские поделки на восьмой категории отбраковки памяти именитых производителей нередко выхаживают больше заявленного ресурса. Что уж говорить о мейнстримовых гигантах.

К слову о любителях локальных объемных архивов — таковые будут вероятнее всего размещены на НЖМД. Если не в компьютере, то в NAS. Там большие скорости обычно не нужны, а объемы в пересчете на цену гигабайта хранения сегодня просто очень дешевы. И если вы боитесь облаков, то домашний рейд из HDD с избыточностью гарантированно сохранит архивы надолго и недорого. Вполне вероятно, что в этой или похожей нише, а так же в дата-центрах с относительно холодными данными, жить им еще долго, как продукту.

Но вернемся к твердотельным накопителям. Statista.com сообщает нам следующую информацию:

- В 2015 на рынок поставили 470 миллионов HDD и 105 миллионов твердотельных накопителей.

- В 2016 — 425 и 140 соответственно.

- В 2017 — 395 и 190.

Паритет будет достигнут ориентировочно в 2020 году и далее рыночная доля НЖМД начнет сокращаться, уступив первенство твердотельным накопителям.