Нещодавно компанія Apple анонсувала набір функцій Apple Intelligence на базі штучного інтелекту для пристроїв iPad, Mac і старших iPhone 15. Тепер представлена документація щодо Apple Intelligence, з якої стало зрозуміло, що під час навчання своїх моделей ШІ компанія раптово відмовилася від передових прискорювачів обчислень Nvidia H100 та серверів на їхній основі. Замість них використовувалися системи зі спеціалізованими чипами Google TPUv4 і TPUv5.

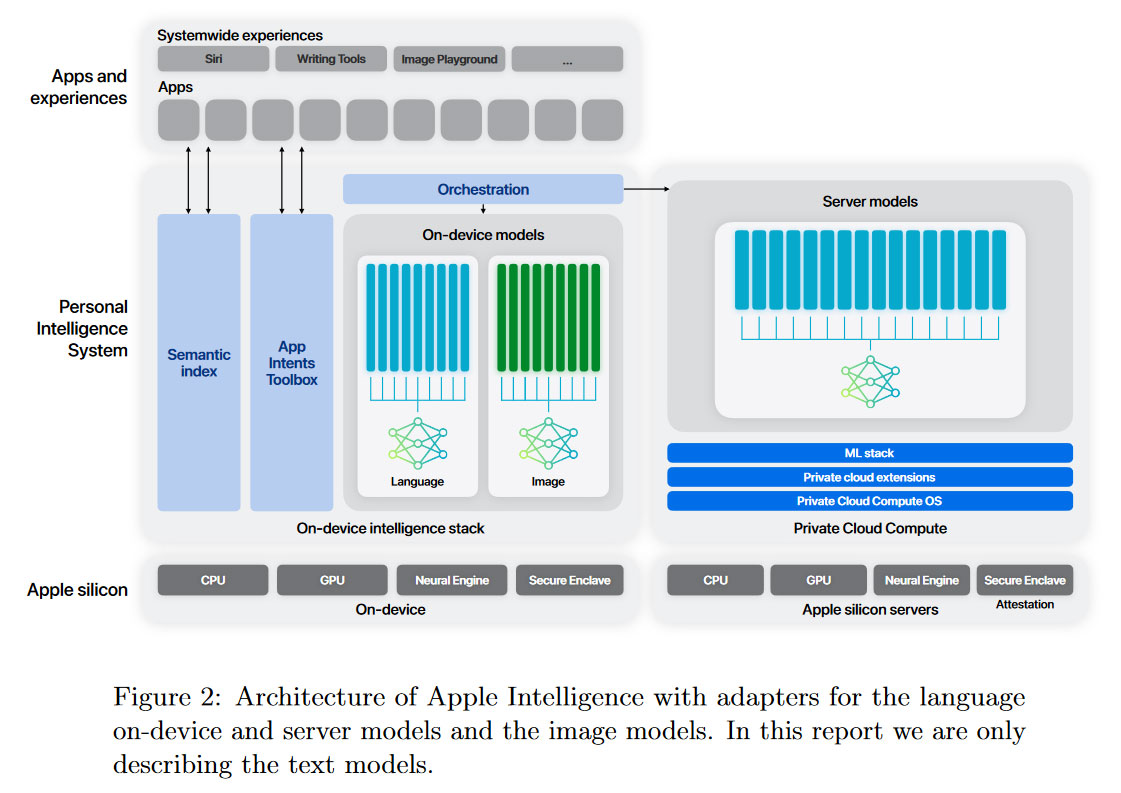

Системи на базі чипів Google TPU (Tensor Processing Units) використовували для навчання моделей Apple Foundation Models (AFM), які представлено у варіантах AFM-server та AFM-on-device для онлайнових і офлайнових функцій. AFM-server є найбільшою мовною моделлю LLM Apple, навченою на 8192 чипах TPUv4 у конфігурації 8×1024 чипів. Попереднє навчання представляло триетапний процес з обробкою загалом понад 7 трильйонів токенів. Дані для навчання отримані від вебсканера Applebot, також використовувалися різні ліцензовані «високоякісні» набори даних. Згадується використання ретельно відібраного коду, математичних обчислень та загальнодоступних наборів даних. У разі моделей AFM-on-device використовували кластер із 2048 чипами Google TPUv5p.

Згідно з внутрішніми тестами Apple їхні моделі показують чудові результати. Тож компанія сподівається зайняти серйозні позиції в перегонах ШІ попри те, що останньою виходить на цей ринок.

Джерело:

Tom's Hardware