Особенности GK110

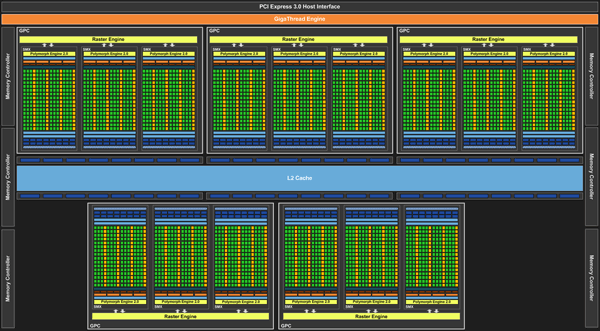

Для начала посмотрим не схему нового процессора GK110. В его основе пять процессорных кластеров GPC, каждый из которых включает по три мультипроцессорных блока SMX. У GK104, на котором базируется GeForce GTX 680, четыре GPC по два SMX.

Один из SMX не активен. Пустые места на схеме тоже немного смущают, но в реальности никаких скрытых «резервов» в виде еще одного GPC у GK110 больше нет. Небольшое «урезание» чипа, возможно, связано с необходимостью вписаться в разумные рамки энергопотребления и тепловыделения. Не стоит забывать и технологические проблемы с производством столь сложного графического чипа. Вероятно, процент выхода полноценных рабочих чипов до сих пор не очень высокий, поэтому NVIDIA решила экономически более целесообразным выпустить Titan на слегка урезанном чипе. В свое время в подобной ситуации оказался GeForce GTX 480, который значительно припозднился со сроками появления да еще и «потерял» по пути часть вычислительных блоков.

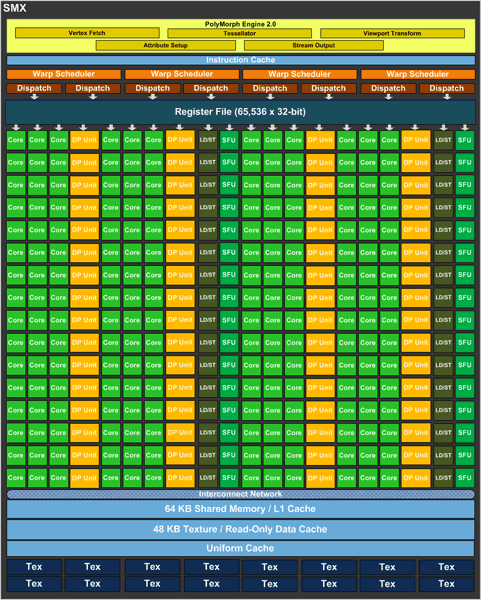

Структура блоков SMX мало чем отличается от привычных SMX у других GPU семейства Kepler. Каждый насчитывает 192 потоковых процессора и 16 текстурных блока. Главное преимущество над более простыми видеокартами NVIDIA у этих SMX — в большéм количестве специальных блоков (DP Unit) для выполнения вычислений двойной точности FP64. Их 64, в то время как у GK104 один SMX насчитывал всего лишь восемь таких юнитов. Так что в специализированных неграфических вычислениях преимущество Titan над GeForce GTX 680 должно быть колоссальным. Размеры блока текстурного кэша на нижней схеме наводят на мысли о некотором его увеличении, но официальных данных на этот счет у нас нет.

14 SMX дают в итоге 2688 потоковых процессоров и 224 текстурных блоков. Это на 75% больше чем у GK104! Увеличилось и количество ROP, теперь их 48 против 32. Шина памяти расширена с 256 до 384 бит. Все это звучит очень внушительно. Но реализовать такие преимущества в полной мере не удастся из-за невысоких рабочих частот GK110. Так что не стоит ожидать роста производительности 75% относительно GeForce GTX 680. А вот частота памяти осталась без изменений — это 6008 МГц. Так что тут мы сразу получаем увеличение пропускной способности памяти на 50% относительно флагмана шестисотой серии.

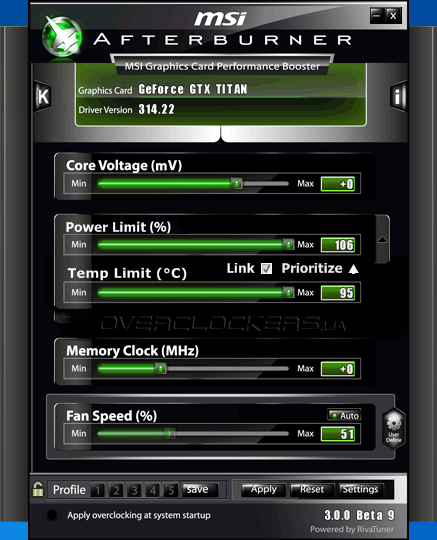

Прежде чем говорить о частотах ядра, нужно немного разобраться в особенностях работы обновленного GPU Boost 2.0. Эта технология обеспечивает разгон графического процессора до определенного уровня. Разгон этот работает так, чтобы не были превышены определенные лимиты по мощности и температуре. И если раньше GPU Boost зависел в первую очередь именно от мощности, то теперь не менее важную роль играет температура. На практике, нагрев карты для итогового значения частоты теперь даже важнее того, насколько близко видеокарта подобралась к лимиту по мощности. Для температуры установлен порог в 80 °C. Чем ниже температура, тем выше будет частота Boost. При превышении порога частота пойдет на спад, но ниже базового уровня упасть не должна. Для GeForce GTX Titan базовое значение 836 МГц, а Boost Clock (среднее значение авторазгона) — 876 МГц. Напомним, что у GeForce GTX 680 эти частоты равны 1006 МГц и 1059 МГц.

В специализированных утилитах пользователю доступны настройки лимита мощности и температуры. При этом можно изменять приоритетное значение. Повысить температурный лимит можно до внушительного значения в 106 °C, по мощности больше 6% сверх нормы не накинуть. А еще мы наконец-то получили возможность повышать напряжение, чего так не хватало у старших моделей GeForce шестисотой серии.

Стоит еще упомянуть, что указанные значения частот актуальны для игрового режима, в котором Titan не в полную силу работает в среде вычислений FP64. Фактически он не использует все свои DP Unit. Для их активации нужно войти в «Панель управления NVIDIA» и в параметрах 3D выбрать пункт «CUDA — double precision». Но в таком режиме видеокарта не вписывается в свои ограничения по мощности и изначально работает на более низких частотах. Не очень честно, но поскольку продукт рассчитан по большей мере на игроков, то ничего страшного в таких ухищрениях нет. Геймеры от более медленных по умолчанию вычислений FP64 ничего не теряют.

Объем памяти расширен до внушительных 6 ГБ. Загрузить их все сейчас будет весьма проблематично. Это явно залог на будущее. Нынче 6 ГБ могут быть востребованы в мультимониторных конфигурациях, особенно для 3D-режима. А если мощности одного GPU для такого режима не хватит, то можно использовать SLI. Для мощнейшей связки из двух или трех GeForce GTX Titan эффективный объем буфера в 6 ГБ будет очень кстати. Кстати, по данным NVIDIA три Titan в SLI обеспечивают примерно 46 fps в Crysis 3 при максимальном качестве графики со сглаживанием MSAA 2x в итоговом разрешении 5760×1080 (три монитора 1920x1080). Фантастический результат для самой красивой и ресурсоемкой современной игры. Плюс ко всему нам обещают самый низкий шум в сравнении с тройной конфигурацией из GeForce GTX 680 или Radeon HD 7970.

Сравнить характеристики нового видеоадаптера с топовыми представителями последних серий можно в нижней таблице.

| Видеоадаптер | GeForce GTX Titan | GeForce GTX 680 | GeForce GTX 580 | GeForce GTX 480 |

| Ядро | GK110 | GK104 | GF110 | GF100 |

| Количество транзисторов, млн. шт | 7100 | 3500 | 3000 | 3200 |

| Техпроцесс, нм | 28 | 28 | 40 | 40 |

| Площадь ядра, кв. мм | 561 | 294 | 520 | 526 |

| Количество потоковых процессоров | 2688 | 1536 | 512 | 480 |

| Количество текстурных блоков | 224 | 128 | 64 | 60 |

| Количество блоков рендеринга | 48 | 32 | 48 | 48 |

| Частота ядра, МГц | 836–876 | 1006–1059 | 772 (1544)* | 701 (1401*) |

| Шина памяти, бит | 384 | 256 | 384 | 384 |

| Тип памяти | GDDR5 | GDDR5 | GDDR5 | GDDR5 |

| Частота памяти, МГц | 6008 | 6008 | 4008 | 3696 |

| Объём памяти, МБ | 6144 | 2048 | 1536 | 1536 |

| Поддерживаемая версия DirectX | 11.1 | 11.1 | 11 | 11 |

| Интерфейс | PCI-E 3.0 | PCI-E 3.0 | PCI-E 2.0 | PCI-E 2.0 |

| Заявленный уровень мощности, Вт | 250 | 195 | 244 | 250 |

Заявленный уровень мощности для GeForce GTX Titan равен 250 Вт, что заметно выше чем у GeForce GTX 680. Это как раз на уровне упоминавшегося выше GeForce GTX 480. Тем более, что по размерам кристалла GK110 нагнал и даже чуть перегнал GF100. Но не стоит думать, что Titan такой же горячий и шумный. Система охлаждения в очередной раз улучшена, а контакт поверхности кристалла с теплосъемником реализован без использования теплораспределительной крышки, что обеспечивает хорошую эффективность в отводе и рассеивании тепла. Так что с охлаждением и шумом проблем нет. Более подробно о конструктивных особенностях мы поговорим ниже.

Titan принес с собой одну прелюбопытную возможность, которую обеспечивает GPU Boost 2.0. NVIDIA именует это «разгоном монитора». При помощи специальных утилит можно повысить pixel clock, что в итоге даст большую частоту обновления изображения. И в качестве примера озвучивается такое значение как 80 Гц вместо 60 Гц. Весьма неплохо для тех, кто любит играть в динамичные шутеры с высокой частотой кадров при активной вертикальной синхронизации. Правда, работать такой разгон будет не на всех мониторах — нужно экспериментировать. У нас пока не было времени на практическое исследование, да и не совсем ясно какие программные средства дают такие возможности. Но в будущем обязательно испробуем и такой разгон.

Еще NVIDIA акцентирует внимание на возможности использования GeForce GTX Titan в компактных системах стандарта SFF (small form factor) благодаря тому, что размеры новичка сопоставимы с GeForce GTX 680, а не с GeForce GTX 690. То есть Titan максимально возможный по производительности вариант для систем SFF, да при этом еще и более чем тихий в сравнении с тем же GeForce GTX 680. Ниже вы можете лицезреть один из примеров таких компактных корпусов — Falcon Northwest Tiki.

Естественно, что имеется полная поддержка всех технологий, с которыми работают и другие GeForce. Это NVIDIA PhysX, 3D Vision и Adaptive VSync. Новое сглаживание TXAA, отличающее минимальной ресурсоемкостью, работает и на Titan.

Теперь настало время взглянуть на живой образец этого «титанического» видеоадаптера.