Объекты данного материала самые яркие представители этой категории. Мы познакомим вас с абсолютно новым High-End видеоадаптером GeForce GTX 280, и его предшественником в лице GeForce 9800 GX2. Обе эти карты сейчас самые дорогие на рынке, но при этом и самые быстрые. Старая карта демонстрирует такую мощь благодаря двум графическим чипам G92, а в основе новой - GPU последнего поколения GT200. Но обе отличаются огромными габаритами, "горячим нравом" и высоким энергопотреблением. Кто же быстрее и мощнее из этих двух монстров, мы и выясним ниже.

Особенности архитектуры GT200

После G80 NVIDIA не торопилась с кардинальными изменениями в архитектуре своих графических процессоров. Популярный G92 практически повторял предшественника, лишь ROP и текстурные блоки были немного улучшены. Новый же чип представляет собой следующее поколение универсальной шейдерной архитектуры, хотя, на самом деле, в основе его все так же лежит базовая архитектура G80.

Ядро GT200 состоит из десяти больших кластеров TPC (Texture Processing Clusters), что на два кластера больше, чем у представителей прошлого поколения. Строение этих вычислительных блоков аналогично предшественникам, но потоковых процессоров (SP) стало больше. На каждый TPC приходится по три потоковых мультипроцессорных юнита (SM), каждый из которых состоит из трех стрим-процессоров. Итого, в общем, получаем 240 универсальных потоковых процессоров. Для каждого SM-юнита выделена своя память объемом 16 КБ.

Основные изменения в шейдерных блоках коснулись модернизации локального регистрового файла, что дало прирост производительности при выполнении сложных программ-шейдеров. Также новый чип обладает возможностью выполнения двух инструкций за такт в одном шейдере. Точность вычислений с плавающей запятой увеличено до 64 бит.

Блоки TMU и ROP остались такими же, как и G92, но их количество было увеличено: до 80 текстурных блоков (по восемь на каждый TPC) и до 32 блоков растеризации, по восемь на каждый широкий ROP. Благодаря улучшениям текстурных блоков, NVIDIA говорит о 22% превосходстве в текстурировании относительно предшественника. Эффективность блоков ROP увеличена в возможности вывода до 32 пикселей с блендингом за такт, тогда как тот же G80 мог выводить только 24 пикселя и 12 с блендингом. Все вышесказанное касается старшего представителя на базе GT200 - GeForce GTX 280. Более доступное решение GeForce GTX 260 отличается чуть меньших числом функциональных блоков.

Но не только возможности по обработке графических задач были улучшены в новом чипе. Благодаря технологии CUDA, GT200 теперь может похвастаться поддержкой и других вычислительных задач. В таком режиме он работает как мультипроцессор с 240 вычислительными ядрами. Это позволит использовать эти видеокарты в специализированных расчетах. Справедливости ради, стоит отметить, что акселераторы Radeon уже давно обладают такой возможностью.

Большие вычислительные возможности чипа подтолкнули компанию на организацию расчетов физики в играх силами GPU. Эта технология является развитием технологии PhysX компании Ageia, которую недавно купила NVIDIA. Хотя тот факт, что энтузиастам удалось "взломать" драйверы NVIDIA и ввести поддержку аппаратного расчета физической модели в видеокарты Radeon, говорит о том, что PhysX не относится к каким-либо аппаратным особенностям графического чипа GT200, а является лишь соответствующей адаптацией программного API PhysX под универсальную щейдерную архитектуру.

Теперь, что касается еще одного нововведения. Шина памяти 512 бит (восемь 64-битных контроллеров памяти) при использовании GDDR3 позволила достичь пропускной способности в 141,67 Гб/с, и по этому критерию решение NVIDIA является лидером на рынке графических акселераторов. Но тут стоит отметить, что AMD пошла другим путем, и в своем новой графическом чипе RV770 ввела поддержку сверхбыстрой памяти GDDR5. Возможно, с выпуском новых GPU калифорнийцы также перейдут на использование прогрессивного типа памяти. Объем памяти у видеокарт GeForce GTX 280 составляет 1 ГБ, что для Hi-end решений становится уже нормой, учитывая аппетиты современных игровых приложений при выборе качественной графики. GeForce GTX 260 довольствуется лишь 896 мегабайтами памяти, при этом шина памяти составляет 448 бит.

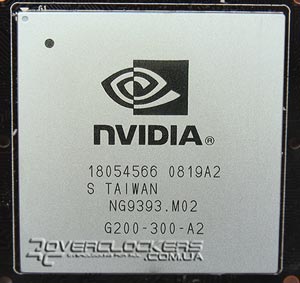

GT200 выполняется по нормам 65-нм техпроцесса. В этом плане AMD пока лидирует - их новые чипы выполнены по 55–нм техпроцессу. Обладая огромных количеством транзисторов (1,4 млрд.) новый чип NVIDIA имеет громадную площадь в 576 кв. мм., а ширина кристалла достигает 2,4 см! С таким огромным ядром добиться выхода большого процента исправных чипов довольно тяжело, поэтому производство GT200 достаточно дорогое, что выливается в высокую окончательную стоимость готового продукта. Ниже приведено фото кристалла со схемой размещения его главных вычислительных блоков.

При таких размерах остро встает вопрос отведения тепла от кристалла. Да и энергопотребление у GT200 самое большое среди всех существующих чипов. Плата на базе GT200 в 3D потребляет до 236 Вт, а в 2D около 25 Вт: в зависимости от загрузки драйвер изменяет рабочую частоту чипа в большую или меньшую сторону. Опять же, подобные технологии уже давно прижились в продуктах ATI/AMD.

Также большой размер кристалла вынудил вынести блоки, отвечающие за интерфейсы (два RAMDAC, два Dual DVI, HDMI, DisplayPort, HDTV) в отдельный чип NVIO, что когда-то уже было с картами на базе G80. Из остальных интерфейсов отметим поддержку PCI Express 2.0 и двух разъемов для объединений видеокарт в режиме SLI и 3-way SLI.

Поддерживается технология HybridPower. При использовании материнской платы с данной технологией и встроенной видеокартой, внешняя в простое может быть отключена, а функции вывода изображения ложатся на плечи интегрированного графического ядра.

Никуда не делись возможности по аппаратному ускорению видео высокого разрешения, но и изменений нет. Все тот же PureVideo HD второго поколения, как и в предыдущих продуктах. Поддерживается вывод изображения через HDMI и DisplayPort.

А вот чего действительно не хватает в новом продукте, так это поддержки DirectX 10.1 и ShaderModel 4.1 - остался лишь "старый" DirectX 10.0. Конечно, программные преимущества обновленного API пока еще не используются разработчиками игр, но пора бы уже ввести поддержку соответствующих инструкций, тем более в новый топовый чип.

Подводя общие итоги по архитектуре, стоит отметить, что ничего кардинально со времен G92/G80 не поменялось, а все вычислительные блоки в среднем были увеличены в два раза. Остальные изменения коснулись лишь доработки функциональности этих самых блоков.

В таблицу, представленную ниже, занесены данные всех основных одночиповых решений различных поколений.

| Видеокарта | GeForce GTX 280 | GeForce GTX 260 | GeForce 9800 GTX | GeForce 8800 GTS | GeForce 8800 GTX |

| Ядро | GT200 | GT200 | G92 | G92 | G80 |

| Число транзисторов, млн. | 1400 | 1400 | 754 | 754 | 681 |

| Техпроцесс, нм | 65 | 65 | 65 | 65 | 90 |

| Число процессоров | 240 | 192 | 128 | 128 | 128 |

| Число TMU | 80 | 64 | 64 | 64 | 32 |

| Число ROP | 32 | 28 | 16 | 16 | 24 |

| Частота ядра, МГц | 602 | 576 | 675 | 650 | 575 |

| Частота процессоров, МГц | 1296 | 1242 | 1688 | 1625 | 1350 |

| Частота памяти, МГц | 2214 | 2000 | 2200 | 1940 | 1800 |

| Шина памяти, бит | 512 | 448 | 256 | 256 | 384 |

| Тип памяти | GDDR3 | GDDR3 | GDDR3 | GDDR3 | GDDR3 |

| Объем памяти, МБ | 1024 | 896 | 512 | 512 | 768 |

| Пропускная способность памяти, ГБ/с | 142 | 112 | 70,4 | 62 | 86,4 |

| Интерфейс | PCI Express 2.0 | PCI Express 2.0 | PCI Express 2.0 | PCI Express 2.0 | PCI Express 1.1 |

| Поддерживаемая версия DirectX | 10 | 10 | 10 | 10 | 10 |

| Энергопотребление, Вт | 236 | 182 | 168 | 140 | 177 |

XpertVision GeForce GTX 280

Новый видеоадаптер от NVIDIA мы рассмотрим на примере продукта компании XpertVision, хотя на самом деле все карты, выпускаемые на данный момент, являются референсными, производимыми на "одном заводе". Делая свой выбор в пользу того или иного бренда, вы платите лишь за имя и комплектацию.

Видеокарта, которая попала к нам, как раз и отличалась весьма скудной комплектацией, что для такого дорого продукта очень непривычно:

- Переходник DVI/D-Sub;

- Переходник DVI/ HDMI;

- Диск с драйверами;

- Инструкция по установке.

Модель от XpertVision в качестве отличительных знаков имеет лишь наклейку на вентиляторе. Строгий черный кожух двуслотового кулера с наклонным вентилятором закрывает всю плату размером 270x100 мм. Задняя сторона тоже полностью закрыта металлической пластиной, которая служит и радиатором для чипов памяти и усиливает жесткость конструкции, предотвращая изгиб.

Вся информация о видеокарте нанесена на боковую стенку. Кстати, наклейки со штрих-кодом нанесены на место стыка верхней и нижней части кулера, так что снятие его чревато повреждением их и, соответственно, потерей гарантии.

С внешней боковой стороны расположены два разъема питания (6-pin и 8-pin). Разъемы SLI и S/PDIF (для подключения звука) закрыты резиновыми заглушками.

Сняв систему охлаждения, вряд ли можно будет увидеть что-то новое. Кулер по конструкции полностью повторяет аналоги на картах GeForce 8800GTS/9800GTX: медный сердечник посредством тепловых трубок передает тепло от ядра к тонким алюминиевым ребрам, которые продуваются турбиной. После чего отработанный воздух выходит наружу системного блока.

Да и сам дизайн платы недалеко ушел от дизайна PCB карт на базе G80, только защитной рамки вокруг чипа нет:

Ядро GT200, в связи со своими размерами обзавелось теплораспределительной крышкой, позволяющей также избежать сколов кристалла.

В качестве памяти используются микросхемы Hynix со временем доступа 0,8 мс (H5RS5223CFR-N2C) с номинальной частотой 2200 МГц и общим объемом 1024 МБ.

Мониторинг и разгон

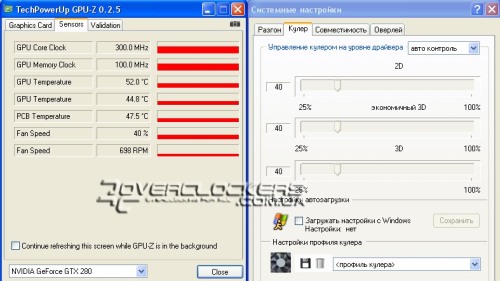

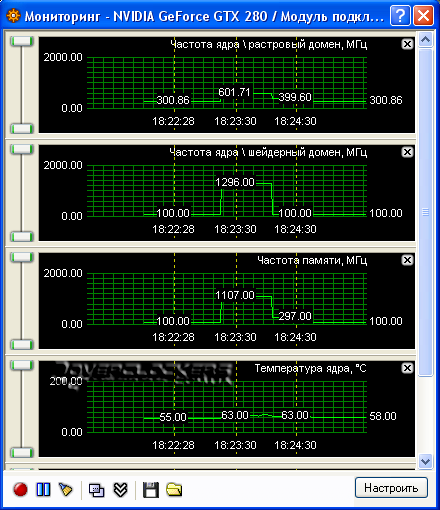

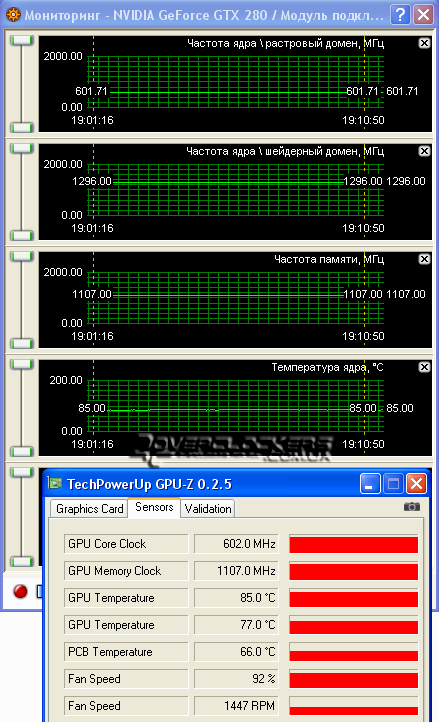

Чип работает на частоте 602 МГц, при этом шейдерные блоки на 1296 МГц. Память GDDR3 функционирует на эффективных 2214 МГц (1107 МГц физических). Но такие частоты включаются лишь при загрузке GPU. В простое эти значения составляют лишь 300/100/200 МГц (ядро/шейдерный домен/память). При увеличении нагрузки ядро может быть установлено на частоту 400 МГц, память 594 МГц. А вот шейдерные блоки, судя по наблюдению, принимают лишь два дискретных значения.

Так же есть инерционность при переключении из высокочастотного режима в низкочастотный. При уменьшении нагрузки изменение частот происходит с запазданием в несколько секунд, вначале принимая средние значения, а потом уже опускаясь до минимальных.

RivaTuner 2.09 работает с новыми видеокартами, но скорость оборотов вентилятора не определяет. Эти данные можно просмотреть в утилите GPU-Z. Хотя управлять оборотами из меню RivaTuner можно, причем здесь положение ползунка соответствует активному на данный момент скоростному режиму в процентах.

Для измерения температуры мы традиционно использовали 10-минутный тест ATITool. Стоит отметить, что если вначале карта не нагрелась выше 81°C, то после двухчасового тестирования в играх, "волосатый куб" ATITool уже легко разогревал ядро до 85°C. При этом обороты поднимались до 92% от номинала. Это практически предел возможностей кулера, что свидетельствует о его низкой эффективности для охлаждения такой горячей карты.

Отдельно стоит отметить шумовые характеристики. GeForce GTX 280 можно смело назвать чемпионом по создаваемому шуму. Гул турбины слышен даже при работе в 2D. В 3D-режиме уровень шума достигает и превышает все мыслимые комфортные пороги. Сидеть за компьютером, в котором работает такая карта, не только неприятно, но и искренне становится жаль того, кто это "чудо" себе купит. В общем если вам не по душе постоянный гул от компьютера как от пылесоса, то готовьтесь в придачу к такой видеокарте купить сразу мощный альтернативный кулер.

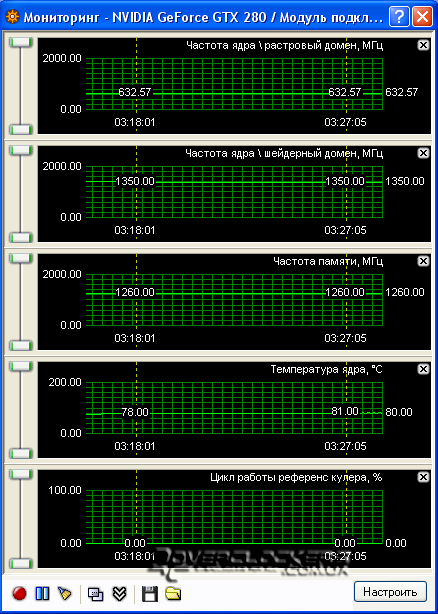

Что касается разгона, то он оказался минимальный. Судя по артефактам, все упирается в охлаждение. Также нет возможности гнать отдельно растровый и шейдерный домены. Эта возможность в RivaTuner включается, но пока не работает. Частоты все равно изменяются синхронно, или даже могут сброситься до минимального порога. Видеокарту удалось разогнать до 633/1350/2520 МГц. По ядру это лишь на 5% выше номинала (что и разгоном то не назовешь), по памяти - 13% выше номинала. Учитывая изначально высокую ПСП этой видеокарты, можно предположить, что разгон памяти роли на итоговой производительности не играет.

Для разгона обороты вентилятора были подняты до 100% что позволило добиться даже более низкой температуры чем та, до которой карта прогревалась при 92% оборотах. ZOTAC GeForce 9800GX2

Главным соперником новой видеокарты GeForce GTX 280 выступает мультичиповый GeForce 9800 GX2, основанный на двух ядрах G92-450. Эта видеокарта до выхода представителя нового поколения занимала место самого производительного продукта. Посмотрим, сможет ли ее победить новое одночиповое решение. Самое интересное, что суммарное количество вычислительных блоков GeForce 9800 GX2 одинаково с одночиповым GeForce GTX 280.

В отличие от компании AMD, которая видит будущее в таки мультиядерных решениях, NVIDIA продолжает концентрировать силы на разработке одночиповых карт. Выпуск GeForce 9800 GX2 был вынужденным ответом на Radeon HD3870 X2, так как новое поколение находилось в стадии разработки, а лавры лидера никто и никому не собирался отдавать. Учитывая, что одноядерная GeForce 8800GTS 512MB запросто превосходит Radeon HD 3870 по производительности, не мудрствуя лукаво, NVIDIA взяла да и объединила две платы в SLI в пределах одного корпуса. Изначально жизненный путь GeForce 9800 GX2 должен был быть очень коротким, но как мы увидим ниже, не стоит возлагать большие надежды на новое поколение и "старичок" еще очень даже успешно конкурирует с новым High-End-видеоадаптером.

В качестве представителя GeForce 9800 GX2 к нам на тестирование попала видеокарта от компании ZOTAC.

Но опять же, все High-End-акселераторы на базе чипов NVIDIA повторяют референс и отличаются лишь комплектацией.

Комплектация:

- Два переходника DVI/D-Sub;

- Переходник питания с "молекса" на 6-pin;

- Переходник питания с "молекса" на 8-pin;

- Кабель HDMI;

- Аудиокабель для подключения звука;

- Диск с драйверами;

- Полная версия игры LOST: Via Domus;

- Инструкция по установке.

Внешний вид видеокарты не сильно отличается от GTX 280. Все такой же массивный «кирпич» закованный в металлический корпус. Вот только теперь не видно турбины.

Устройство этой карты вы можете оценить по нижеприведенному слайду из документации NVIDIA.

Карты расположены по бокам конструкции и повернуты чипами и памятью вовнутрь, а между ними расположена система охлаждения, турбина которой, захватывая воздух через отверстия в платах, прогоняет его между ребрами радиатора и выбрасывает часть за пределы корпуса, а часть воздуха, причем большую, - обратно в системный блок (как в GeForce 9600 GT).

Для циркуляции воздушного потока в кожухе есть вентиляционные отверстия.

Одна из плат является главной - без установки драйвера работает только она одна. Поэтому при подключении монитора его нужно воткнуть в нижний разъем DVI под номером 1.

Кроме разъемов DVI имеется также HDMI, так что, переходники при подключении цифрового приемника видеосигнала не понадобятся. Внешние разъемы и коннекторы питания подсвечиваются. Энергопотребление платы ниже GeForce GTX 280 и составляет 197 Вт в пике. NVIDIA каждую плату в составе GeForce 9800 GX2 наделила своей памятью объемом 512 МБ, которая в SLI, как мы помним не суммируется.

Мониторинг и разгон

В соответствии со спецификацией данная видеокарта работает на частотах - 602/1512 МГц (ядро), 1998 МГц (физические 999 МГц) память. У данного видеоадаптера скорость оборотов турбины-кулера не определяется ни одной утилитой. Но в разделе управления кулером в RivaTuner скорость отображается в процентном соотношении и имеется возможность регулировать обороты турбины. Стартует вентилятор с немного более высоких оборотов чем у GeForce GTX 280, но зато и температура чипов немного меньше. В тесте ATITool температура ядер держалась на уровне 83-84°C.

Температурные датчики есть не только в каждом чипе, но и на каждой плате.

По шумовым характеристикам система охлаждения соответствует таковой у GeForce GTX 280. То есть, так же сильно гудит, но зато со своей задачей справляется немного лучше.

Разгон у этой карты оказался не выдающийся, особенно, учитывая результаты разгона GeForce 8800GTS в нашем прошлом обзоре. Рассматриваемая же модель стабильно работала на частотах 702/1728/2130 МГц (ядро/стрим-процессоры/память). Более высокие значения приводили к зависанию системы в некоторых тестах. Обороты были подняты до максимума, но это не помогло улучшить разгон. Установленный на обдув 120-мм вентилятор тоже не изменил ситуацию, хотя еще на пару градусов температура снизилась. Зависания обычно являются признаком нехватки мощности, но используемого на тестовом стенде блока питания на 1 кВт должно было хватать с лихвой.

| Видеокарта | XpertVision GeForce GTX 280 1GB | ZOTAC GeForce 9800GX2 512MB |

| Кодовое имя процессора | GT200 | 2 x G92-450 |

| Техпроцесс, нм | 65 | 65 |

| Частота ядра, МГц | 602 | 602 |

| Частота унифицированных шейдерных блоков, МГц | 1296 | 1512 |

| Количество унифицированных шейдерных блоков | 240 | 2 x 128 |

| Количество текстурных блоков TMU | 80 | 2 x 64 |

| Блоков блендинга ROP | 32 | 2 x 16 |

| Частота памяти, МГц | 2214 | 1998 |

| Разрядность интерфейса памяти, бит | 512 | 2 x 256 |

Тестовый стенд:

- Процессор: Core 2 Duo E8400 3 ГГц (разогнанный до 4 ГГц, 445 МГц FSB);

- Кулер: Thermalright Ultra-120 eXtreme;

- Материнская плата: Gigabyte P35-S3;

- Память: 2х2GB OCZ PC6400 (890 МГц при таймингах 5-5-5-15);

- Жесткий диск: 320GB Hitachi T7K250;

- Блок питания: Chieftec CFT-1000G-DF;

- Операционная система: Windows XP SP2, Windows Vista Ultimate SP1;

- Драйвера: ForceWare 177.41 для GTX 280, ForceWare 175.19 для 9800GX2;

Для сравнения с предыдущим поколением, в графики были добавлены результаты ASUS GeForce 8800 GTS 512MB из прошлого тестирования. Для этой карты использовались чуть более старые драйвера версии ForceWare 175.16.

Результаты тестирования в DirectX 9

3DMark 2006 (DX9)

В этом синтетическом тесте лидирует GeForce 9800 GX2. Она на 33% процента быстрее GeForce 8800 GTS и на 8% быстрее GeForce GTX 280 на номинальных частотах.

S.T.A.L.K.E.R. (DX9)

Традиционно первым игровым тестом выступает этот популярный отечественный шутер.

Все настройки графики на максимум, анизотропная фильтрация включена. Тест проводился на первой локации "Кордон".

Ситуация в этой игре повторяет расстановку сил в предыдущем тесте. Опять на первом месте двухчиповая видеокарта. Новичок уступает ей 10-14%, но обгоняет видеокарту 8-й серии на 30-40%, которая, благодаря неплохому потенциалу, в разгоне сокращает этот разрыв.

TimeShift (DX9)

Настройки графики максимальные, включена фильтрация AF16x. Небольшой игровой эпизод переигрывался по три раза для более точного результата.

В низком разрешении наблюдается паритет между двумя главными соперниками, но лучший разгон позволяет двухчиповой модели опередить новичка. А вот в более тяжелом режиме изначально лидирует GeForce 9800 GX2.

Unreal Tournament 3 (DX9)

Популярный сетевой шутер. На движке этой игры создано множество других популярных проектов, так что производительность в этом приложении очень показательна.

Настройки графики максимальные. Тест проводился на уровне ShangriLa без ботов. Для каждого режима тест проводился по три раза.

И снова паритет между соперниками в низком разрешении, и безоговорочное лидерство GeForce 9800GX2 в высоком. Примечательно, что игра неплохо реагирует на мультичиповые решения, карта с двумя G92 на 75% быстрее одного G92.

Call of Duty 4 (DX9)

Одна из лучших игр прошлого года.

Тестирование проводилось на уровне WarPig. Данный игровой эпизод отличается множеством ботов, взрывов, дыма в кадре. Результаты построены по итогам пятикратного прогона данного игрового эпизода, чтобы уменьшить погрешность.

В общем-то, все видно на графиках, снова GeForce GTX 280 занимает почетное второе место. Учитывая цену на эту карту, хотелось бы наконец-то увидеть, чтобы она хоть где-то обогнала представителя прошлой серии.

Legend: Hand of God (DX9)

Diablo-клон с красивой графикой.

Все настройки графики максимальные. Графический движок игры не отличается оптимизацией, тем более интересно, какие результаты будут на столь мощных видеокартах.

Говорить об однозначной победе GeForce GTX 280 в этой игре нельзя. Производительность всех видеокарт без активации сглаживания примерно на одном уровне. Кстати, эта игра явно безразлична к SLI. GeForce 8800GTS умудряется даже слегка обогнать GeForce 9800GX2. А вот активация фильтрации и сглаживания сразу выводит на первое место новичка. Видно, что у GT200 все же есть порох в пороховницах.

Race Driver: GRID (DX9)

Отличный автосимулятор с красивой графикой на движке Colin McRae Rally DIRT.

Настройки графики максимальные. Результатов GeForce 8800GTS с MSAA 4х нет, поскольку эта карта в прошлый раз тестировалась в другом режиме сглаживания.

Паритет в низком разрешении и небольшое, но все же преимущество GeForce 9800 GX2 в высоком разрешении.

Crysis (DX9)

Самая высокотехнологичная игра современности и самая спорная. Если большой интерес игровым процессом она и не вызывает, то в графическом плане вне всяких похвал. Поэтому результаты в этой игре интересны и многие пользователи ориентируются на эту игру, как на самую ресурсоемкую.

Для тестов использовался стандартный GPU-бенчмарк.

Уверенная победа нового флагмана, в низком разрешении он обгоняет соперника на 20%, в высоком на 12%. Правда, разгон второго позволяет ему немного сократить разрыв, но даже в разгоне он не может достигнуть показателей старшей модели.

Результаты тестирования в DirectX 10

Devil May Cry4 (DX10)

Первый тест под DirectX 10. Игра хоть и новая, но отличается невысокими системными требованиями.

Настройки графики Very High. Использовался предрелизный игровой benchmark.

И снова первое место остается за двухчиповой картой с отрывом в 15-18% от соперника. Игра оказывается превосходно реагирует на SLI. В высоком разрешении GeForce 9800 GX2 на 98% быстрее одночипового предшественника!

Assassin's Creed (DX10)

Популярная игра.

Тестирование проходило следующим образом: совершалась прогулка по определенному маршруту, включая прогулку по крышам, переулкам и небольшой площади, насыщенной NCP. По троекратным испытаниям получены средние результаты. В высоком разрешении 1600х1200 (реальное игровое разрешение 1600х900) игра просто не позволяет включить сглаживание, поэтому этих результатов для данного разрешения на диаграмме нет.

Не триумф, но уверенная победа GeForce GTX 280 во всех тестируемых режимах. Даже более удачный разгон не позволяет сопернику обогнать модель на GT200.

World in Conflict (DX10)

Популярная стратегия.

Игра довольно требовательная, поэтому мы традиционно протестируем ее при включении анизотропной фильтрации и отдельно при активации фильтрации со сглаживанием. В виду нестабильных результатов встроенного теста, он повторялся по три раза для каждого режима.

Еще одна игра, где уверенно лидирует GeForce GTX 280, причем наибольший отрыв данной видеокарты в тяжелых режимах со сглаживанием. Судя по двум последним играм в DirectX 10 новичок проявляет себя лучше, чем в играх под DirectX 9.

Crysis (DX10)

Тесты под DirectX 10 проводились в пропатченной версии 1.2. Проверим, подтверждается ли наше предположение, что основной потенциал GeForce GTX 280 раскрывается в DirectX 10.

После довольно радостных для GeForce GTX 280 результатов в этой игре под старым API, мы видим, что сейчас уже она не может соперничать с GeForce 9800GX2. Конечно есть двукратное превосходство новичка в высоком разрешении со сглаживанием, но этим показателям далеко до играбельного FPS. Как видим, новые флагманы 3D-ускорителей наконец-то могут обеспечить комфортную производительность в Crysis под DirectX 10, но только лишь в разрешении 1280х1024.

Выводы

Если вы ждали сенсации и прорыва от новых видеоадаптеров NVIDIA, то можете ждать дальше. Прорыва подобного выходу G80, не случилось. Новый чип представляет собой в два раза увеличенный по мощности старый добрый чип G92 с небольшими улучшениями вычислительных блоков. На деле это выливается в то, что предыдущий флагман компании на двух G92 в большинстве игр обгоняет новичка. И это при том, что на GeForce 9800GX2 еще и цена меньше.

Конечно потенциал у новой видеокарты есть, шина 512 бит и большой объем памяти помогают ей иногда поддерживать лидерство в тяжелых режимах. Но проблема именно в этом "иногда". Добавьте к этому более высокое энергопотребление новой видеокарты и ее горячий нрав. Вывод напрашивается сам собой. Если есть более дешевая, часто более быстрая и немного более прохладная (все же температура ее чипов меньше) GeForce 9800 GX2, то зачем нам что-то другое и более дорогое?

Но есть и довольно веский аргумент в пользу новой модели. Многочиповые решения имеют определенные проблемы с программной оптимизацией. В нашем тестировании была лишь одна игра, где явно видно, что потенциал двух G92 не используется. В Legend: Hand of God GeForce 9800GX2 даже уступила пару процентов одночиповому предшественнику с более высокими чатсотами. В остальных же играх двухчиповый GeForce всегда обгонял GeForce 8800GTS, и иногда довольно существенно. Так что не так страшен SLI, как его рисуют. По крайней мере, так обстоят дела на 32-разрядных операционных системах. На x64, по отзывам, дела с оптимизацией обстоят похуже. Последние борцы за одночиповые решения могут вспомнить и характерные "лаги" у двухчиповых карт. Да, такое имеет место быть. Но из всех протестированных игр это явно было заметно лишь в Crysis. В остальных играх игровой процесс если не идеален, то кратковременные просадки производительности не заметны. Видеокарта мощная, и если даже будет просадка от 100 до 50 FPS, то 90% игроков этого просто не почувствуют.

На фоне таких приятных умозаключений напрашивается еще один вопрос. А зачем нам тогда и GeForce 9800GX2 нужен? Если за ее цену можно спокойно взять две GeForce 8800 GTS и поставить их в SLI. При этом карты будут лучше охлаждаться, что позволит даже больше их разогнать. Ведь GeForce 9800 GX2 практически ничем не отличается от того же SLI, который можно получить на материнской плате.

Если же сравнивать цены на рассмотренные сегодня продукты с их уровнем производительности, то становится ясно, что 50-100% прироста производительности над одной 8800GTS выливаются в 2-3 кратное увеличение цены. При этом вы получаете печку с невыносимым уровнем шума. Платить 500-700 у.е. за топовый акселератор, чтобы играть затыкая уши? Бред. Так что, сразу же приготовьтесь менять стандартную систему охлаждения, и желательно на СВО.

Положа руку на сердце, стоит сказать, что продукты подобные GeForce 9800 GX2 и GeForce GTX 280 в соотношении "цена/производительность" не самые привлекательные варианты. Но High-End всегда таким был. Мы переплачиваем за возможность купить уже сейчас, то, что через год будет стоить в два раза дешевле. Но все же хотелось бы за такие деньги получить готовый к "употреблению" продукт, а не конструктор для энтузиастов. Если вы не считаетесь с финансами и всегда мечтали собрать себе SLI из двух или трех мощнейших видеокарт, при этом в придачу организовать СВО, то рассмотренные модели как раз то, что надо. Мощнее и горячее их пока нет. :)

В одном из ближайших материалов мы постараемся познакомить вас с новыми мощными видеоадаптерами от AMD и NVIDIA меньшей ценовой категории. Сравним их с данными топовыми моделями и выясним, какая модель все же самая эффективная в соотношении "цена/производительность".