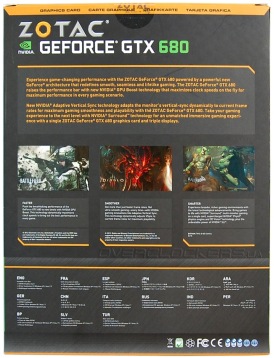

К нам в руки попала видеокарта от Zotac. Упаковка немного изменилась. Ранее топовые GeForce компания предлагала в компактных блестящих коробках с изображением драконов. Нынешняя упаковка больше, но выглядит проще.

Внутри еще одна коробка из плотного черного картона.

Комплектация богатая:

- переходник DVI/D-Sub;

- два переходника питания c двух molex на PCI-E 6-pin;

- диск с драйвером;

- полная версия игры Assassin's Creed;

- полная версия игры Assassin’s Creed II;

- полная версия игры Assassin’s Creed: Revelations;

- код для трехдневного доступа TrackMania 2 Canyon;

- инструкции.

Сбоку большими рельефными буквами значится надпись GeForce. Как и остальные флагманские продукты, GeForce GTX 680 имеет два разъема для объединения нескольких видеокарт в SLI.

Интересно расположены разъемы дополнительного питания. Второй разъем чуть сдвинуть вглубь и размещен сверху над первым. Их взаимное расположение совсем не мешает подключению и извлечению кабелей питания. Но высокая колодка может помешать установке альтернативных систем охлаждения.

Родная система охлаждения традиционно представляет собой «турбину» с выдувом горячего воздуха за пределы корпуса. Внешне GeForce GTX 680 мало чем отличается от GeForce GTX 580, разве что стало чуть больше «лоска» из-за блестящей поверхности кожуха.

На задней панели расположены разъемы Display Port, HDMI и два DVI. Они занимают значительную площадь, поэтому отверстий для выхлопа воздуха не так уж и много. Частично он реализован и вовнутрь корпуса через прорези сбоку карты возле разъемов SLI.

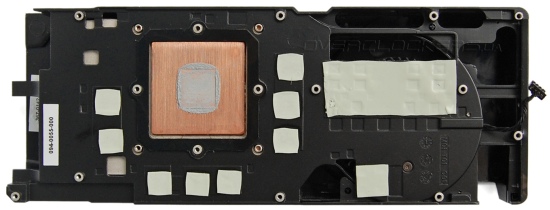

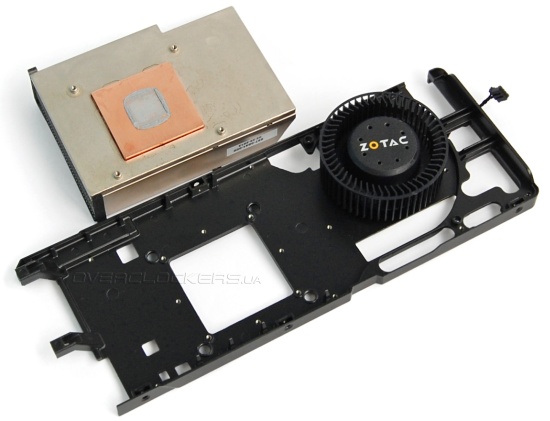

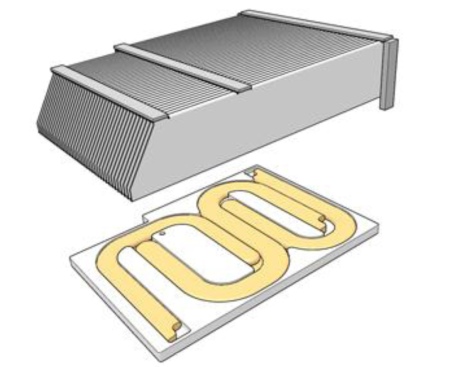

На первый взгляд конструкция кулера не претерпела серьезных изменений. Всю поверхность платы накрывает пластина-радиатор, охлаждающая VRM и память.

На GPU установлен радиатор с массивным основанием и рядом напаянных алюминиевых пластин.

Но основной радиатор стал поменьше. И теперь в основании нет испарительной камеры, как у GeForce GTX 580. Но с учетом меньшего тепловыделения нового графического процесса такая небольшая экономия и упрощения со стороны NVIDIA вполне понятны.

Контакт с поверхностью кристалла осуществляется через медную вставку. А внутри основания в желобках имеются три приплющенные тепловые трубки. Сверху на все это напаян массив пластин, продуваемых радиальным вентилятором.

Оценить размеры системы охлаждения можно по нижней фотографии собранной видеокарты без верхнего кожуха.

Со слов NVIDIA в производстве видеокарты использовались демпфирующие материалы, гасящие акустический шум. Так что кожух должен играть и роль шумоподавителя. Не знаем насколько это соответствует действительно, в любом случае эффективность такого шумоподавителя будет минимальная. Однако щепетильное внимание к мелочам со стороны компании радует.

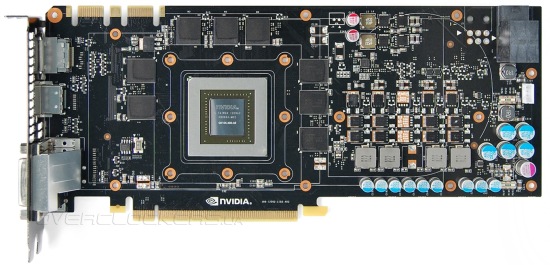

Возле колодки с разъемами питания есть посадочное место под второй разъем. Так что вполне возможно появление в продаже референсных моделей с традиционным расположением разъемов при использовании нестандартного охлаждения. Некоторые из таких видеокарт уже мелькали в нашей новостной ленте. Дизайн платы отличается от GeForce GTX 580.

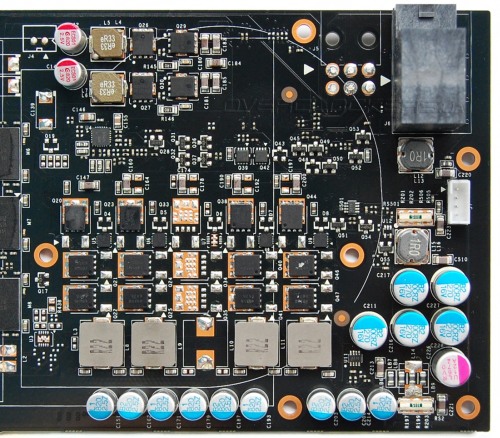

GPU запитан от четырехфазного преобразователя (у GTX 580 было шесть фаз), память GDDR5 — от двухфазного. Не распаяна одна фаза. Возможно, первоначальный вариант видеокарты планировался на более мощном чипе или NVIDIA проектировала PCB с запасом для будущих продуктов.

Питанием графического процессора управляет контроллер Richtek RT8802A, который распаян на небольшой дочерней плате.

Впервые старший GPU от NVIDIA не имеет теплораспределительной крышки. Во избежание повреждения оголенного кристалла его окружили большой защитной рамкой. Судя по маркировке GK104-400-A2, это не первая ревизия данного графического процессора. Возможно, GPU A1 планировались для более слабых видеоадаптеров, а после перепрофилирования предполагаемого GeForce GTX 660 в GeForce GTX 680 процессор был доработан и переведен на большие частоты, получив ревизию A2.

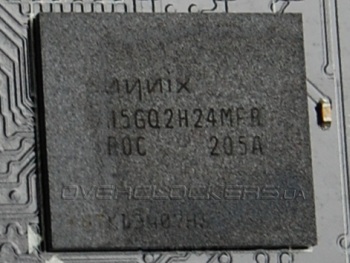

Два гигабайта видеопамяти набраны восемью микросхемами Hynix H5GQ2H24MFR R0C. Микросхемы рассчитаны на рабочую частоту 6 ГГц, что как раз соответствует стандартным характеристикам GeForce GTX 680. И запас для разгона, предположительно, будет небольшой.

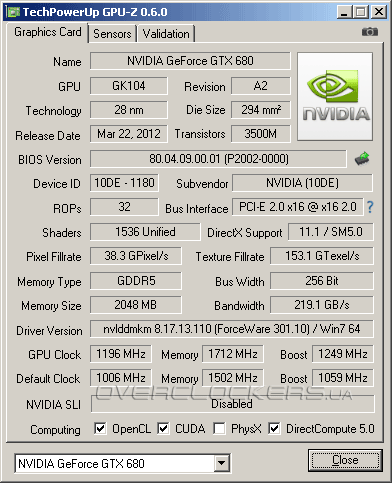

Утилита GPU-Z версии 6.0.0 правильно определяет все параметры видеокарты. Кроме базовой частоты в 1006 МГц указывается и Boost Clock. Память функционирует на эффективной частоте в 6008 МГц.

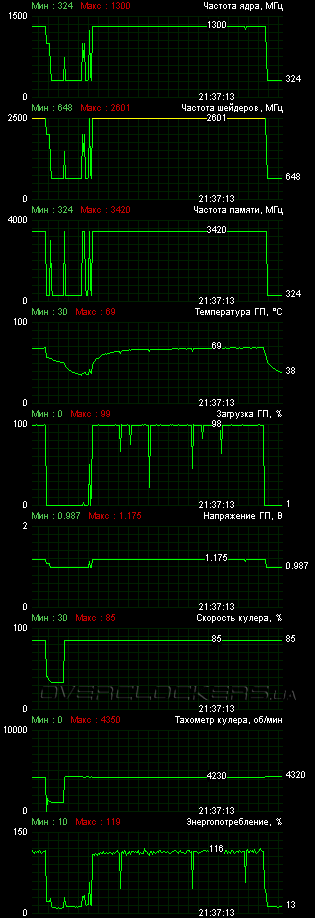

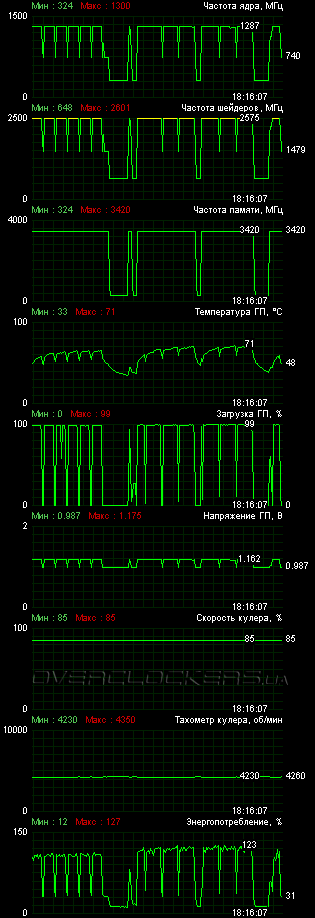

Для мониторинга параметров и разгона видеокарты мы использовали MSI Afterburner 2.2.0 beta 15. Программа по старой памяти демонстрирует удвоенную частоту шейдернго домена, но в реальности все блоки у Kepler работают на одной частоте. Наш стандартный 12-минутный тест Crysis: Warhead на максимальных настройках качества со сглаживанием 8x прогрел карту лишь до 81 °C при 24 градусах внутри помещения. При этом энергопотребление почти все время было ниже 100%, что позволяло ядру большую часть времени работать на 1084 МГц, иногда поднимаясь и до 1110 МГц. Вместе с частотой динамически изменяется и рабочее напряжение.

В более ресурсоемких новых играх разгон будет меньше. К примеру, в демо Central Park из Adrenaline Crysis 2 Benchmark Tool частоты графического процессора большую часть времени держались на уровне Boost Clock 1058 МГц.

Вентилятор раскручивался до 2400 об/мин. Шум умеренный. Напрямую сравнить GeForce GTX 680 с референсным Radeon HD 7970 у нас не было возможности. Но то, что новинка тише и холоднее GeForce GTX 580, можем сказать уверенно.

Технология GPU Boost простым геймерам-оверклокерам жизнь никак не усложнит. Порядок разгона прост: вначале поднимаем предел энергопотребления, потом разгоняем. Без увеличения предела не обойтись, ведь частоты видеокарты зависят от уровня энергопотребления. Вполне может случиться, что видеокарта будет сбрасывать частоты ниже тех, что вы установили при разгоне. Тогда прирост производительности не будет соответствовать приросту по частотам. Кстати, одним лишь увеличением предела тоже можно немного разогнать GPU, не изменяя его базовую частоту, он будет все время работать с наибольшим ускорением.

Мы установили максимальный предел энергопотребления в 132%, но все равно достигнуть полной стабильности при базовой частоте свыше 1200 МГц не удавалось. После длительного подбора частот и прогона разных тестов, остановились на +190 МГц. То есть базовая частота в итоге составила 1196 МГц. Напряжение даже не пришлось повышать, оно само увеличивается с увеличением частоты. Память стабильно заработала на 6848 МГц.

Самое интересное, что с максимальным порогом энергопотребления в большинстве приложений GPU почти всегда работал с максимально возможным ускорением на 104 МГц, т.е. при 1300 МГц. Это наглядно иллюстрирует скриншот загрузки в Crysis: Warhead. При этом энергопотребление не превышало 119%.

Самой большой «грелкой» для видеокарты оказался Witcher 2, прогревая ядро больше других игр. Но даже в этом приложении при разгоне видеокарта не превышала предел в 132% и работала на частотах близких к 1300 МГц.

У нас сложилось впечатление, что разгон по базовой частоте свыше 1,2 ГГц не пошел лишь из-за ограничений по энергопотреблению. Никаких артефактов на больших частотах не наблюдалось, просто некоторые приложения начинали периодически подвисать, а другие работали стабильно. Вообще разгонный потенциал у GK104 явно выше потенциала Tahiti. Но полностью раскрыть его при жестком контроле мощности не удастся. Если не задирать предел до максимума, можно добиться большей базовой частоты, но тогда снизится Boost-частота. В итоге мы все равно получим тот же уровень производительности, что и ранее. Подобное мы уже наблюдали у Radeon HD 7900: производительность при большей частоте без повышения PowerTune соответствует меньшей частоте с максимальным пределом PowerTune.

Отметим еще, что разгон мы осуществляли при максимальных оборотах вентилятора. Режим мало практичный, ведь шум очень высокий. Впрочем, и частоты разогнанного Radeon HD 7970 в нашем тестировании достижимы на референсе только при высоких оборотах и шуме. Поэтому основные конкуренты в равных условиях. А мы получим возможность сравнить потенциал каждой видеокарты.